Завод по производству оборудования для видеонаблюдения с искусственным интеллектом

Когда слышишь про ИИ в видеонаблюдении, многие сразу представляют футуристичные сцены из фильмов. На деле же наш завод в Нижнем Новгороде прошел путь от простых камер до систем, где нейросети анализируют поведение толпы на вокзалах — и это не рекламный ход, а ежедневная рутина. Кстати, часто путают: ИИ — не просто 'умный' детектор движения, а например распознавание оставленных предметов в метро, где алгоритмы обучались на тысячах часов реальных записей.

Технологические вызовы при интеграции ИИ в промышленное оборудование

Первая проблема, с которой столкнулись — температурные режимы. Камеры для карьеров должны работать при -50°C, а нейронные сети резко теряют точность при перегреве процессоров. Пришлось совместно с инженерами АО Юэян Суофейт Майнс Экипмент разрабатывать гибридную систему охлаждения — часть решений взяли из их опыта создания подвесных транспортных систем для шахт, где тоже критичен перегрев электроники.

Второй момент — энергопотребление. На удаленных объектах, где мы тестировали прототипы, иногда проще провести отдельную линию электропередач, чем оптимизировать алгоритмы. Сейчас используем процессоры с архитектурой RISC-V, но до идеала далеко — в режиме постоянной аналитики батарея садится за 6 часов.

Любопытный кейс: на одном из заводов по добыче угля система ИИ сначала выдавала 47% ложных срабатываний по распознаванию техники. Оказалось, пыль от угля создавала на объективе узоры, которые алгоритм воспринимал как трещины в оборудовании. Пришлось добавлять в обучение данные с имитацией загрязнений — сейчас процент ложных тревог упал до 3.8.

Практические аспекты производства камер с компьютерным зрением

Сборка на конвейере — это только верхушка айсберга. Например, калибровка объективов под ИИ-аналитику занимает 3 дня, потому что нужно учитывать дисторсию не только для человеческого глаза, но и для нейросети. Мы даже ввели должность 'инженер по оптическим искажениям' — таких специалистов в России можно пересчитать по пальцам.

Прошивки обновляем ежеквартально, но это головная боль: камеры, установленные на высоте 20 метров в портах, приходится обслуживать с подъемников. Один раз при обновлении 'по воздуху' 12 камер в Владивостоке ушли в бесконечную перезагрузку — пришлось останавливать погрузку судна на 5 часов. Теперь все обновления тестируем на стенде, имитирующем спутниковую связь.

Интересно получилось с защитой от взлома: изначально использовали стандартные TLS-сертификаты, но для задач видеонаблюдения с искусственным интеллектом этого оказалось мало. Разработали собственный протокол шифрования видеопотока, где каждый кадр разбивается на пакеты с разными ключами. Правда, пришлось пожертвовать задержкой — теперь она 120 мс вместо 80.

Синергия с промышленными партнерами: опыт АО Юэян Суофейт Майнс Экипмент

Когда мы начали сотрудничать с АО Юэян Суофейт Майнс Экипмент, первое что удивило — их подход к тестированию. Они используют вибростенды, разработанные для горного оборудования, чтобы проверять устойчивость наших камер к вибрациям. На их сайте можно увидеть, как их подвесные системы работают в экстремальных условиях — мы переняли этот принцип 'тестирования с запасом прочности'.

Совместно разработали систему мониторинга конвейерных лент: ИИ не просто фиксирует обрыв, а прогнозирует износ роликов по микровибрациям. Здесь пригодился их опыт в проектировании транспортных систем — мы бы сами никогда не догадались анализировать акустические паттерны.

Кстати, их научно-исследовательское подразделение помогло решить проблему с запотеванием объективов в шахтах. Мы думали о дополнительном подогреве, а они предложили использовать капиллярные покрытия — технология, изначально разработанная для их подземных транспортёров.

Реальные инциденты и как их предотвращали

На металлургическом комбинате в Череповце была история: система ИИ ночью отключила одну из линий охлаждения, приняв пламя за аварию. Расследование показало, что алгоритм обучали на данных летнего периода, а зимой пар от охладителей выглядел иначе. Теперь все модели тренируем на данных всех сезонов — база выросла до 1.2 петабайт.

Другой случай: на химическом заводе камеры с искусственным интеллектом стабильно 'слепли' в районе 14:00. Оказалось, солнце через определенное окно создавало блик, который алгоритм воспринимал как засветку матрицы. Решили установили поляризационные фильтры с автоматическим вращением — простое механическое решение сложной программной проблемы.

Самое сложное — объяснить заказчикам, что ИИ не всесилен. Один раз чуть не потеряли контракт, потому что система не могла различить тень крана от реального препятствия. Пришлось разрабатывать гибридный алгоритм, где классическое компьютерное зрение работает в паре с нейросетями — сейчас это наш стандарт для всех промышленных решений.

Эволюция подходов к обучению нейросетей

Раньше мы как все — брали готовые датасеты COCO, ImageNet. Пока не поняли: для распознавания промышленных аномалий они бесполезны. Теперь снимаем собственные данные месяцами, иногда специально создаем нештатные ситуации на испытательных полигонах. В прошлом квартале потратили 2 недели, чтобы получить всего 37 минут записи реальной аварии конвейера — но это того стоило.

Обнаружили интересный эффект: если обучать нейросеть только на качественных записях, в реальных условиях она работает хуже. Специально добавляем в данные шумы, артефакты сжатия, капли воды на объективе — так называемый 'адверсариальный тренинг'. Точность на идеальных данных падает на 5%, зато на реальных объектах растет на 12%.

Сейчас экспериментируем с transfer learning — берем предобученные модели для медицинской диагностики и доучиваем для технического зрения. Странно, но алгоритмы, определяющие опухоли на рентгене, хорошо справляются с поиском микротрещин в металлоконструкциях. Видимо, есть что-то общее в паттернах аномалий.

Будущее производства: куда движемся

Сейчас тестируем систему, где камеры не просто фиксируют события, а формируют цифрового двойника производства. Например, в цеху с подвесными транспортными системами ИИ в реальном времени строит 3D-карту перемещений и прогнозирует точки столкновений. Пока работает с задержкой в 2 секунды — многовато для быстрых процессов.

Планируем внедрить квантовое машинное обучение для анализа термограмм — обычные нейросети плохо справляются с инфракрасными данными. Партнеры из АО Юэян Суофейт Майнс Экипмент предоставляют свои испытательные площадки, ведь их оборудование часто работает в условиях перепадов температур.

Самое перспективное направление — распределенные вычисления. Вместо передачи видео в облако, аналитика будет происходить прямо в камере, а на сервер пойдут только метаданные. Уже есть прототип, где камера с мобильным процессором обрабатывает 12 кадров в секунду — для статичных сцен хватает, но для динамики нужно как минимум 25 fps.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Защита пассажиров на расстоянии

Защита пассажиров на расстоянии -

Интегрированный зажим с прямым и обратным крюком и черепицей

Интегрированный зажим с прямым и обратным крюком и черепицей -

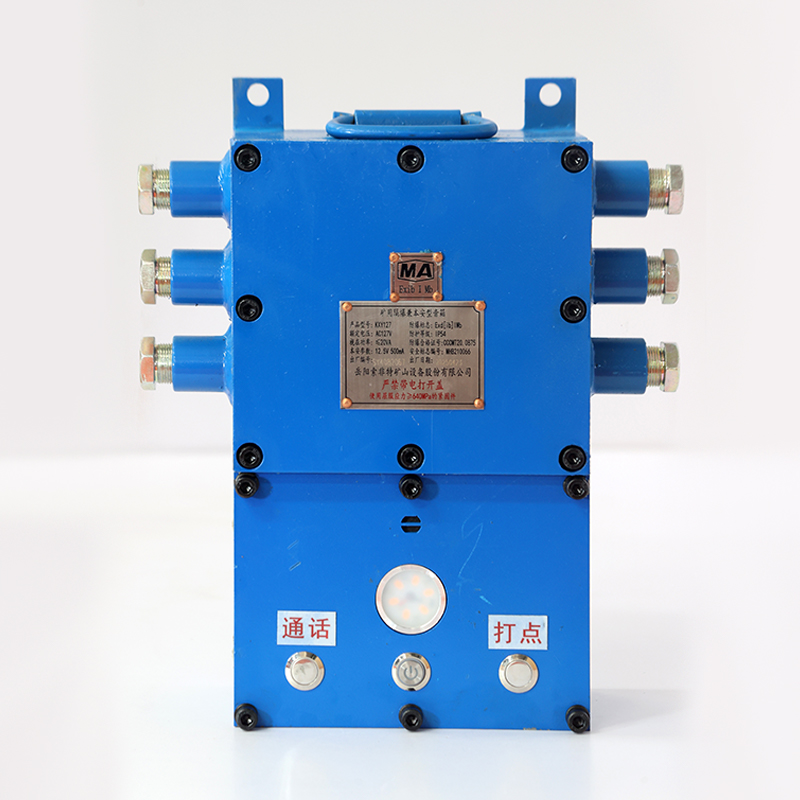

Взрывозащищенный и искробезопасный громкоговоритель для горных работ

Взрывозащищенный и искробезопасный громкоговоритель для горных работ -

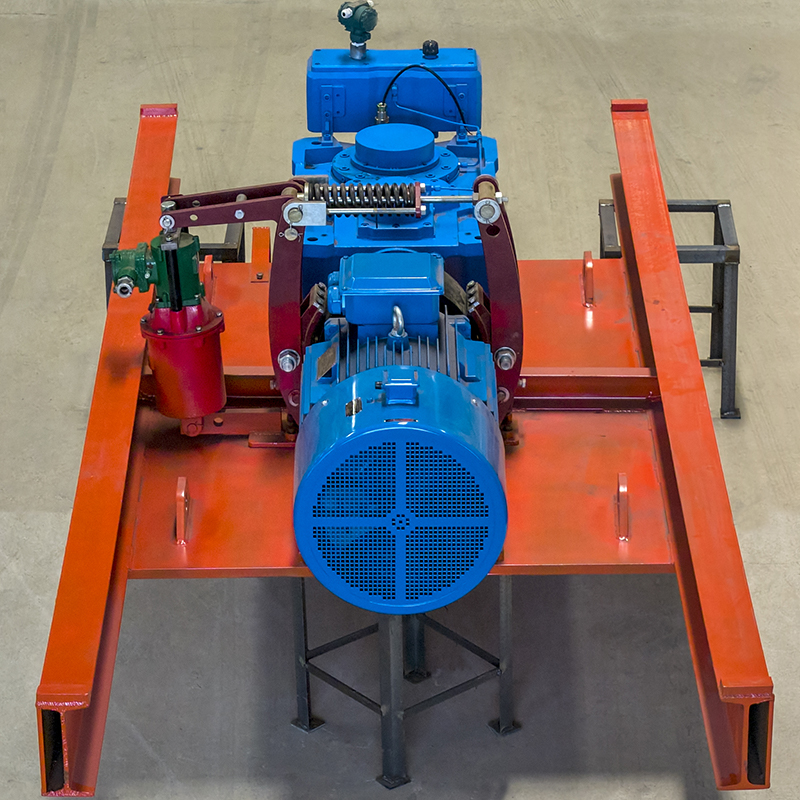

Приводной вал

Приводной вал -

Регулируемый кронштейн подвески

Регулируемый кронштейн подвески -

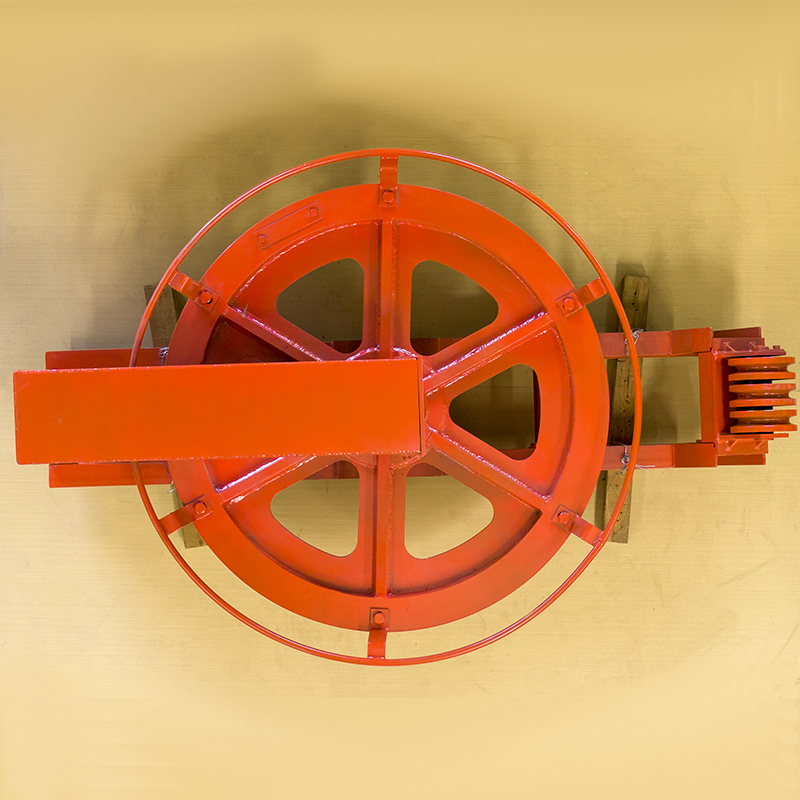

Подвесное транспортное устройство для шахт Хвостовая часть

Подвесное транспортное устройство для шахт Хвостовая часть -

Полуподвесное кресло

Полуподвесное кресло -

Подвесное сиденье из нержавеющей стали

Подвесное сиденье из нержавеющей стали -

Видео наблюдение промышленный компьютер

Видео наблюдение промышленный компьютер -

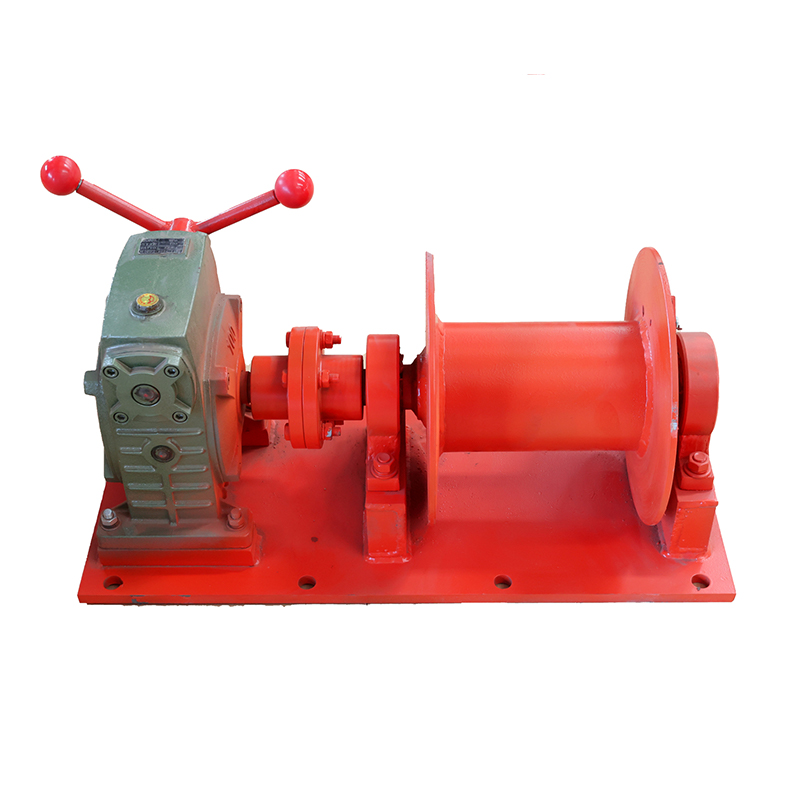

Гравитационный тросовый подъемник

Гравитационный тросовый подъемник -

Подвесное транспортное устройство для шахт Носовая часть

Подвесное транспортное устройство для шахт Носовая часть -

Грузовой натяжитель

Грузовой натяжитель

Связанный поиск

Связанный поиск- Высококачественная гидравлическая станция мощность

- Гидравлическая насосная станция с электроприводом

- Поставщики типов гидравлических станций

- Поставщики датчиков температуры

- 2 цены на датчики давления

- Цена гидравлической станции квт

- Куплю гидравлическую насосную станцию

- Поставщики промышленных контроллеров видеонаблюдения

- Фабрика интегрированной подвески каната против падения

- Установка для электрического управления подвесным путепроводом